什么是百度快照?百度快照不更新了怎么做SEO

12

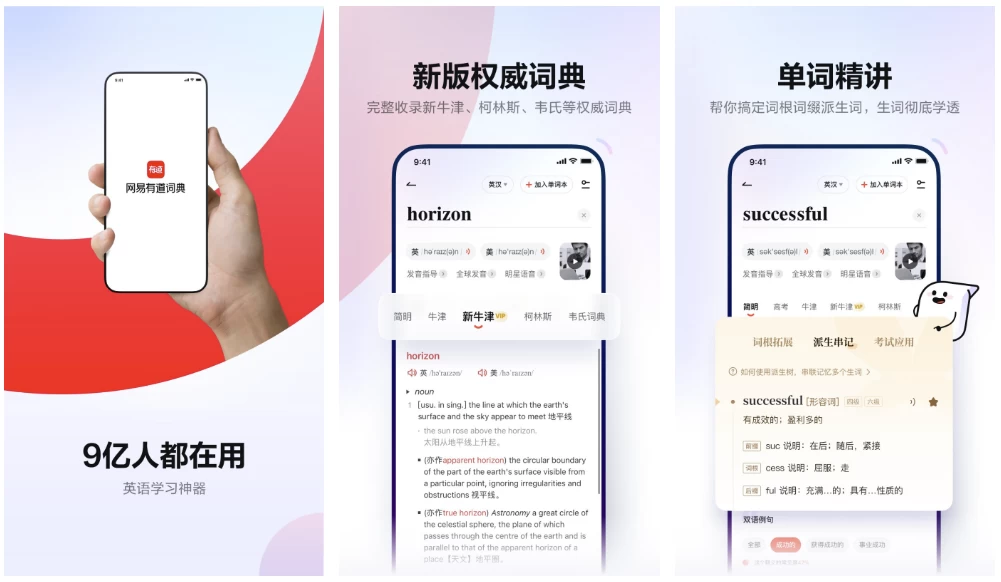

网易有道词典是一款免费的全能翻译软件。有道词典PC版结合了互联网在线词典和桌面词典的优势, 支持41种语言翻译,海量词汇,在线翻译,权威词典、汉语词典、强大的本地词典,“权威词典+网络释义”组合将各类新兴词汇和翻译收录其中,新增的全文翻译、百科全书及网络单词本让英文正式迈入互联网时代。

软件特点

去广告解锁会员版

软件下载

https://pan.quark.cn/s/75dff5a99f78

https://pan.xunlei.com/s/VOP0m38t78sDR3A2L_CgN8LQA1?pwd=rpss

https://url96.ctfile.com/f/60968596-1502186866-4e9bef?p=7788 (访问密码: 7788)